Ziel dieses Arbeitspaketes ist es, mittels KI-Verfahren historische Geodaten zu klassifizieren. Dies soll anhand von Objektbeschreibungen gemäß dem vorgegebenen Objektartenkatalog erfolgen. Somit gilt es historische Kartendaten zu segmentieren und damit in eine objektbasierte Form zu überführen. Für die historischen Bilddaten besteht das Ziel in der Prädiktion von Labelbildern (Klassifikation), wobei jedes Pixels einer Objektart zugeordnet wird.

Da die Klassifikation mittels Deep Learning Verfahren erfolgen soll, besteht ein wichtiger Punkt darin, zunächst Trainingsdaten für die entsprechenden Testgebiete zu erfassen und in der Datenbank bereitzustellen.

Die übergeordneten Aufgaben gliedern sich in die Klassifikation von Luft- und Satellitenbildern und die der historischen Karten sowie die gemeinsame Klassifikation von Karten und Bildern.

Georeferenzierung historischer Karten und Klassifikation von ausgewählten Objekten in diesen Karten (LUH-ikg)

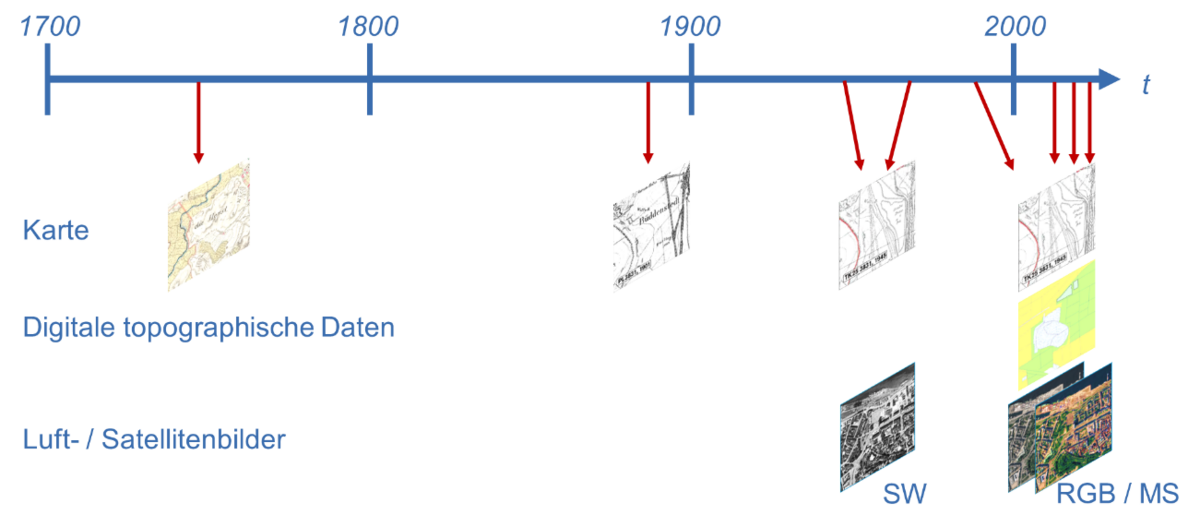

Historische Karten liegen in analoger Form und nach der Digitalisierung im Rasterformat vor. Sie unterscheiden sich von heutigen Karten und digitalen Datenbeständen in unterschiedlicher Weise – zum einen im Inhalt und in der Darstellungsform und zum anderen in der geometrischen Projektion; überdies können sie Verzerrungen und unterschiedliche Generalisierungen aufweisen. Um historische Karten für Zeitreihenanalysen einsetzten zu können, ist es daher zum einen erforderlich, dass die Daten in einem einheitlichen Referenzsystem vorliegen und zum anderen, dass die Daten in vektorisierter Form zur Verfügung stehen, und zwar mit vergleichbarer Semantik wie die aktuellen Karten. Daher fallen im Wesentlichen zwei Arbeitsschritte an: (1) Interpretation der historischen Karten mit aktueller Semantik und (2) Georeferenzierung historischer Karten.

- Im Rahmen des Projekts wird eine Konzentration der Interpretation auf ausgewählte, wesentliche Objekte erfolgen. Hierfür sollen DeepLearning-Verfahren (speziell Convolutional Neural Networks - CNNs) eingesetzt werden. Es erfolgt zunächst eine Konzentration auf punktförmige Objekte, da diese sich mit Standardklassifikatoren erfahrungsgemäß sicherer ermitteln lassen. Hierzu zählen Signaturen von Städten oder Vegetation. Darüber hinaus sollen auch solche Objekte betrachtet werden, die für den Schritt der automatischen Georeferenzierung eingesetzt werden können. Um dem Problem der großen erforderlichen Mengen an referenzierten Objekten zu begegnen, soll Self-supervised Learning eingesetzt werden, welches sich in Vorarbeiten als erfolgreich erwiesen hat. Aufgrund der sehr unterschiedlichen kartographischen Gestaltungsvorgaben der verschiedenen Karten kann es erforderlich sein, hierarchische Ansätze zu nutzen, um somit auch mit unterschiedlichen Symbolgrößen umgehen zu können. Das Ergebnis dieses Arbeitsschritts sind interpretierte Kartenbereiche, die in der Datenbank abgelegt werden.

- Das Ziel der automatischen Georeferenzierung historischer Karten soll durch Matchingverfahren erreicht werden, bei dem das zu entwickelnde System nach vergleichbaren Objekten in beiden Datenbeständen sucht, diese einander zuordnet und unter Verwendung von parametrisch gegebenen Transformationen den geometrischen Zusammenhang zwischen den Datenbeständen herstellt. Als Matchingkandidaten sollen Objekte herangezogen werden, die über einen längeren Zeitraum hinweg eine große Bedeutung haben, und die sich auch mit den aus 1) entwickelten Verfahren extrahieren lassen, beispielsweise Städte, Kirchen, Brücken, Kreuzungen. Das Verfahren wird exemplarisch an ausgewählten Kartenbeispielen demonstriert. Diese Verfahren werden anhand verschiedener historischer Karten untersucht, womit deren Übertragbarkeit gezeigt wird.

Klassifikation von Bildern (LUH-IPI)

Das Ziel ist die Entwicklung einer Methodik zur Klassifikation von Luft- und / oder Satellitenbildern anhand des zuvor definierten Objektartenkatalogs. Damit soll in erster Linie die Forschungsfrage beantwortet werden, welche Informationen sich mittels KI aus historischen Daten ableiten lassen sowie in wie weit sich solche Methoden auf andere Daten übertragen lassen in Hinblick auf Luft- und Satellitenbilder eines einzigen Zeitpunkts. Zu diesem Zweck wird eine auf CNN basierende Methode zur pixelweisen Klassifikation von georeferenzierten Luftbildern implementiert und getestet. Zunächst wird auf Basis von vorhandenen CNN-Architekturen zur pixelweisen Klassifikation von Bildern eine geeignete Encoder-Decoder-Architektur ausgewählt und an die vorliegende Fragenstellung angepasst. Für das Training werden zunächst Standardverfahren für unausbalancierte Klassenverteilungen herangezogen und an die hier vorliegenden Daten angepasst. Bei den dabei genutzten Bildern handelt es sich um hoch aufgelöste multispektrale Luftbilder, wobei die Auflösung ggf. im Vergleich zu den ursprünglichen Daten (z.B. auf ca. 1,0-1,5 m) reduziert wird, um den Berechnungsaufwand zu reduzieren und eine Anpassung an die Auflösung der zu prädizierenden Labelbilder (ca. 2,5 – 5 m) zu erreichen. Die ersten Tests des entwickelten CNN erfolgen anhand der jüngsten und in Hinblick auf die Qualität der Bilddaten besten verfügbaren Daten. Im Rahmen der Tests soll untersucht werden, welche der ausgewählten Objektarten anhand dieser Daten sicher detektiert werden können. Die Ergebnisse dieser ersten Experimente dienen als Best-Case-Szenario und liefern den Rahmen für weiterführende Untersuchungen, welche die folgenden Fragestellungen betreffen:

- Eignung unterschiedlicher Datenquellen: Für die jüngeren Datensätze jedes Testgebiets werden Bilddaten unterschiedlicher Herkunft vorliegen. Dies ermöglicht eine Analyse der Qualität der Klassifikation in Abhängigkeit von der geometrischen Auflösung und der spektralen Konfiguration der Input-Daten. Damit kann insbesondere die Eignung von frei verfügbaren Fernerkundungsdaten wie z.B. von Sentinel-2, aber auch von Daten anderer Satelliten für die Klassifikation untersucht werden.

- Lernen mit fehlerbehafteten Trainingsdaten: Eine weitere zu untersuchende Fragestellung betrifft die Notwendigkeit für die Verfügbarkeit von Trainingsdaten für alle Epochen. Im Sinne einer potentiellen Reduktion des Aufwands für die Bereitstellung von Trainingsdaten ist zu überprüfen, ob vorhandene digitale topographische Datensätze (ATKIS) auch ohne Korrektur dazu dienen können, die Trainingslabels für die Klassifikation von Bildern anderer Zeitpunkte zu liefern. Zu diesem Zweck ist die Trainingsprozedur so zu adaptieren, dass Fehler in diesen Trainingslabels („Label Noise“) kompensiert werden können.

- Generalisierungsfähigkeit der Klassifikatoren: In weiteren Experimenten sind die entwickelten Methoden, die sich in den unter Punkt 1) und 2) genannten Untersuchungen als am vielversprechendsten erwiesen haben, in Hinblick auf ihre Fähigkeit zur Generalisierung zu analysieren. Dabei werden aus den Daten verschiedener Gebiete unterschiedliche Mengen von Trainings- und Testdaten zusammengestellt, um die Übertragbarkeit der Methoden auf Daten unterschiedliche Gebiete und unterschiedlicher Sensoren mit bzw. ohne neuen Trainingsdaten zu untersuchen.

In allen Fällen folgen die Experimente den üblichen Protokollen, bei denen Genauigkeitsmaße für die Prädiktionen abgeleitet werden. Dabei erweitert sich im Laufe des Projekts die Datengrundlage für die Experimente, was schlussendlich weiterführende Analysen in Hinblick auf die Qualität der Ergebnisse als Funktion der Eigenschaften der Daten erlaubt, wobei auch deren Abhängigkeit von der Bodenbedeckung untersucht werden kann.

Gemeinsame Klassifikation von historischen Karten und Bildern (LUH-IPI)

Im Anschluss an die Entwicklung einer Klassifikationsmethode je Modalität (Karte, Bild) werden multi-modale Verfahren entwickelt, mit deren Hilfe Bild- und Kartendaten ein- und desselben Zeitpunktes für eine pixelweise Klassifikation genutzt werden können. Die zu unterscheidenden Objektarten entsprechen jenen für die Bildklassifikation. Die dabei zugrundeliegende Forschungshypothese ist, dass sich diese unterschiedlichen Datensätze in der Klassifikation gegenseitig stützen können, entweder indem die aus den Bilddaten mittels der CNN abgeleiteten Texturmerkmale die Information aus der Karte in Gebieten ohne Signaturen oder Hintergrundfarbe komplementieren oder indem gewisse Kartensignaturen bei der Unterscheidung von Klassen helfen, die alleine anhand der Bilder nicht getrennt werden können. Dabei wird davon ausgegangen, dass für alle Zeitpunkte gescannte Karten vorliegen, in denen die zu prädizierende Information nur implizit enthalten ist.

Zur Kombination der Daten wird das für die reine Bildklassifikation entwickelte CNN derart erweitert, dass die unterschiedlichen Eingangsdaten (gescannte Karten bzw. Bilddaten) zunächst in separaten Encodern prozessiert werden; die Fusion der beiden Zweige des CNN erfolgt vor dem Übergang zum gemeinsamen Decoder (late fusion). Anschließend wird untersucht, in wie weit die im Rahmen der reinen Kartenklassifikation generierten Ergebnisse, die im Vergleich zu den hier anvisierten Zielen auf einer selektiven Auswahl von Objekten aufbauen, in den gemeinsamen Klassifikationsprozess integriert werden können. Dies könnte z.B. in Form von Rasterkarten mit Wahrscheinlichkeiten für das Auftreten bestimmter Objekte erfolgen, die gemeinsam mit den digitalisierten Karten dem entsprechenden Encoder präsentiert werden.

Ein weiterer Punkt der Untersuchungen bildet die Rolle der digitalen topographischen Daten, die für jüngere Zeitpunkte vorliegen und die aus den Bildern bzw. gescannten Karten zu prädizierende Information bereits explizit abbilden. Diese Daten können in zweifacher Weise für die Klassifikation genutzt werden: einerseits können sie für Zeitpunkte, an denen sie vorliegen, dazu dienen, die Labels für das Training zu liefern, andererseits können sie selbst als zusätzliche Beobachtungen in die Klassifikation einfließen. In beiden Fällen ist allerdings mit Abweichungen des Inhalts der digitalen topographischen Daten von der in den Bildern dargestellten Realität zu rechnen. In Hinblick auf das Training können die im Rahmen der reinen Bildklassifikation gemachten Erfahrungen im Umgang mit der Nutzung von fehlerbehafteten Daten zum Training auf den vorliegenden multi-modalen Fall direkt übertragen werden. Im Zusammenhang mit der gemeinsamen Klassifikation werden im Wesentlichen die gleichen Fragen untersucht wie im Rahmen der reinen Bildklassifikation, allerdings nur für die vielversprechendsten der dort verfolgten Ansätze und mit einem Fokus auf die Änderung der Qualität der Klassifikation, die durch die gemeinsame Prozessierung von Bildern und Karten bzw. topographischen Datensätzen sowie durch die Integration der Ergebnisse aus der reinen Kartenklassifikation auftritt.

Die resultierenden Verfahren zur Klassifikation stellen gemeinsam mit jenen, die ausschließlich auf Karten aufbauen, das endgültige Ergebnis der KI-gestützte Klassifikation von historischen Daten dar. Die dabei erzielten Ergebnisse liefern schließlich die Antwort auf die Forschungsfrage, welche Information sich aus historischen Kartenwerken und Luft- bzw. Satellitenbildern verlässlich ableiten lässt.